Que l’on exerce dans les médias ou que l’on soit simple lecteur, on partage le même constat : le web de 2025 déborde de contenus et d’actualités, et la vérité cherche à se frayer un chemin entre « mésinformation », désinformation et « infox ». Face à cela, le fact-checking est devenu une méthode indispensable pour faire un tri éclairé dans la masse.

Couplée à l’intelligence artificielle, cette discipline promet de gagner en efficacité et de soutenir le rythme effréné du flux de publications qui alimentent la confusion. Mais nous sommes encore loin du compte. Le potentiel est bien là, mais de gros problèmes persistent pour la rendre fiable à 100%.

Alors, pourquoi le fact-checking avec l’IA est toujours aussi compliqué en 2025 ? Explications dans cet article.

La complexité du travail de fact-checking

Un processus qui n’est pas systématisé

En 2023, 62 % des Français déclaraient se rendre sur internet au moins une fois par jour pour consulter de l’information. Et deux tiers d’entre eux le faisant sur les réseaux sociaux.

Sur ces plateformes sociales, tout le monde dispose d’un potentiel médiatique : le volume d’informations explose et les sources se multiplient. Chacun cherche sa vérité, et la rigueur face aux faits s’affaisse.

Dans ce contexte, le fact-checking, ou vérification des faits, est devenu un pilier essentiel du journalisme et de la communication.

La capacité à distinguer le vrai du faux de l’information qui circule en ligne est devenue un besoin vital. Cela permet de remonter à l’intangibilité des faits, et de mettre de côté le brouhaha des avis tranchés et du débat d’idée permanents. En témoignent les lancements successifs de cellules de fact-checking au sein de services de rédaction célèbres (Les Décodeurs du Monde, Checknews de Libération, Vrai ou Faux de France Info…).

Toutefois, le fact-checking n’est pas un processus rigide et systématique, mais une discipline complexe qui repose sur la rigueur, la méthode et le discernement du journaliste.

Fact-checker une information ne consiste pas à faire une recherche sur Google et à cliquer sur les deux premiers résultats pour contrôler qu’ils détiennent, eux aussi, cette même information.

L’exigence de l’exactitude

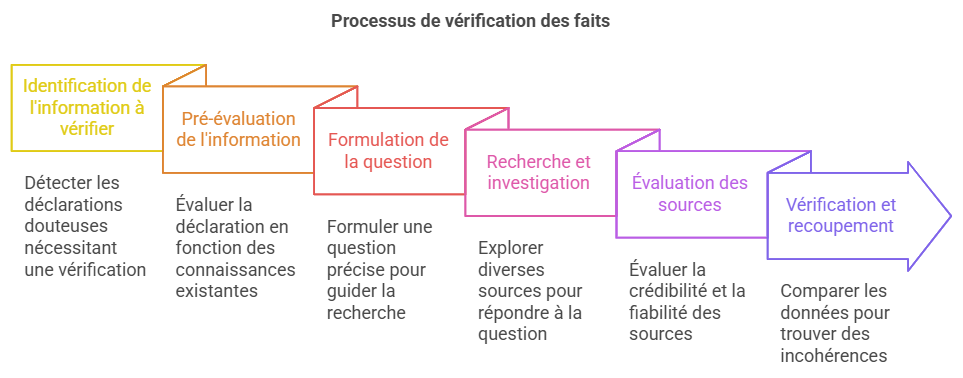

Ainsi, un processus type de fact-checking peut inclure de nombreuses étapes pour atteindre l’exactitude. Il peut par exemple se résumer ainsi :

- Identification de l’information à vérifier : le processus commence par l’identification d’une information, d’une affirmation, d’une statistique ou d’un contenu qui suscite un doute ou une interrogation. Cela peut provenir d’un article de presse, d’un discours politique, d’une publication sur les réseaux sociaux, etc. Parfois, le doute naît d’une affirmation sensationnaliste ou qui semble aller à l’encontre de faits établis.

- Pré-évaluation de l’information : avant de se lancer dans une recherche approfondie, le journaliste s’appuie sur ses connaissances préexistantes et son expertise pour effectuer une première analyse. Une affirmation qui semble conforme à ce qui est déjà connu peut être acceptée avec un minimum de vérification, tandis qu’une information inhabituelle ou mal sourcée appelle une analyse plus poussée.

- Formulation de la question/Recherche contextuelle : le doute initial se traduit en une question précise qui guidera la recherche. Par exemple : « Cette photo est-elle authentique ? », « Cette statistique est-elle exacte ? », « Ce témoignage est-il crédible ? ». Avant de formuler cette question explicite, il faut collecter des éléments contextuels. Il s’agit de comprendre les implications de l’information, ses origines potentielles et sa pertinence.

- Recherche et investigation : le « fact-checker » explore différentes sources d’information pour répondre à la question posée. Il peut s’agir de consulter des bases de données, des archives, des rapports officiels, des articles académiques, des sites web spécialisés, etc. Très souvent, il devra aussi contacter des experts, des témoins ou des personnes concernées par l’information.

- Evaluation des sources : toutes les sources ne se valent pas. Le journaliste en charge de la vérification doit évaluer la crédibilité, la fiabilité et la pertinence de chaque source en tenant compte de facteurs tels que l’auteur, la date de publication, la nature du site web, la présence de biais, etc.

- Vérification et recoupement : le journaliste compare les différentes sources, analyse les données, recherche des contradictions ou des incohérences.

- Conclusion et publication : enfin, il présente les résultats de sa vérification de manière claire et transparente. Il explique la méthodologie utilisée, cite les sources consultées et précise le degré de certitude de ses conclusions. Il identifie également les points à préciser ou les ambiguïtés à signaler.

Pour illustrer ce processus, prenons un exemple.

L’exemple d’un politicien qui affirmerait que « les exportations nationales ont augmenté de 30 % cette année » lors d’une interview en direct.

Le journaliste commencerait par une pré-évaluation (cette statistique est-elle plausible dans le contexte économique actuel ?) basée sur son expertise. Il chercherait ensuite des rapports d’organismes officiels (ministère de l’Économie, INSEE…), consulterait des experts en économie, puis synthétiserait les données pour vérifier si cette augmentation concerne toutes les exportations ou uniquement certains secteurs. Il préciserait également la période de référence pour cette augmentation et la comparerait avec les années précédentes.

Les possibilités de l’IA et leurs performances

Innovation de poids qui touche tous les secteurs d’activité, l’intelligence artificielle n’exempt pas les journalistes de ses superpouvoirs, et elle se positionne comme un outil puissant pour compléter le travail des fact-checkers.

Sur le sujet de la connaissance, les capacités de l’IA générative peuvent être regroupées en trois piliers :

- Connaissances intrinsèques : les modèles d’IA comme ChatGPT s’appuient sur une base de connaissances préexistante issue des données sur lesquelles ils ont été entraînés. Cette approche est efficace pour vérifier des faits bien établis ou intemporels, comme des événements historiques ou des données scientifiques éprouvées. Cependant, elle est limitée par le cadre temporel de l’entraînement : l’IA ne peut pas accéder à des informations postérieures à cette période.

- Recherche en ligne : certains modèles avancés, comme Perplexity, Gemini ou ChatGPT avec navigation Web, permettent de rechercher des informations en temps réel. Cette approche est particulièrement utile pour les sujets d’actualité ou les faits controversés. Toutefois, elle est vulnérable aux biais des sources en ligne et aux informations non vérifiées. Aussi et surtout, il existe une grande disparité sur la fiabilité des résultats « récupérés » par l’IA. Par exemple, ChatGPT Search, la fonctionnalité de recherche en ligne de ChatGPT (activée lorsqu’on clique sur l’icône en forme de mappemonde), se trompe dans plus de 75% des cas !

- Corpus de connaissances spécifiques : une troisième possibilité consiste à entraîner un modèle sur un corpus précis (rapports gouvernementaux, publications scientifiques, bases de données journalistiques…). Cette base de connaissance devient le champ de recherche et d’action de l’IA pour contrôler l’information et apporter une réponse à l’utilisateur. Plutôt que de travailler sur les données astronomiques qui constituent les connaissances « par défaut » d’un modèle de langage comme ChatGPT, cette technique favorise sa spécialisation dans un corpus défini, et améliore la fiabilité de ses réponses. C’est le principe du « RAG » (« Génération Augmentée de Récupération » en français dans le texte). Autre avantage, la base peut être actualisée par le journaliste au besoin, afin que l’IA travaille toujours sur de la donnée « fraîche ».

Exemple d’utilisation combinée pour le fact-checking avec l’IA

Pour vérifier une affirmation sur la réduction des émissions de CO2 d’une entreprise ou d’un pays donné, une IA pourrait :

- Utiliser ses connaissances intrinsèques pour fournir un cadre contextuel.

- Effectuer une recherche en ligne pour trouver des données actualisées.

- Croiser les résultats avec un corpus scientifique spécifique pour valider les informations.

🔑 Cet exemple simple permet de se rendre compte à quel point le travail « besogneux » peut être délégué à l’IA, mais également à quel point un contrôle humain rigoureux reste de mise à toutes les étapes du processus.

Vous cherchez des conseils « opérationnels » pour réussir votre vérification d’information avec ChatGPT ? Découvrez mes 5 techniques préférées pour fact-checker de l’info avec l’IA.

Le problème des hallucinations

Qu’est-ce qu’une hallucination en intelligence artificielle ?

L' »hallucination » d’un modèle d’intelligence artificielle est un terme qui désigne la génération d’une réponse qui, bien que paraissant plausible, est factuellement incorrecte ou entièrement inventée.

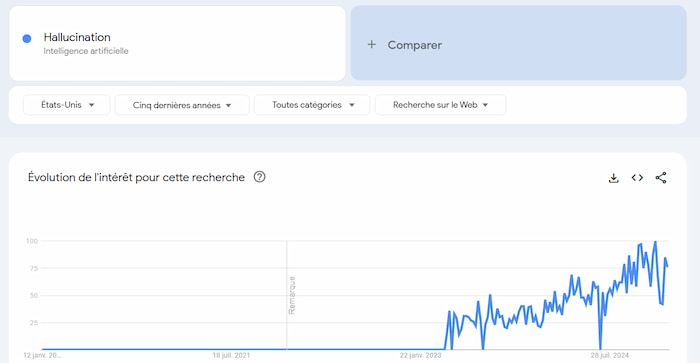

Depuis la démocratisation de ChatGPT fin 2022, le sujet de ces hallucinations a rapidement émergé, pour se positionner comme une notion centrale dans la compréhension des modèles actuels d’IA générative. Sans surprise, son volume de recherche a explosé en conséquence sur la toile.

Voici les tendances de recherche autour du concept des hallucinations sur ces 5 dernières années (USA). Source : Google Trends

Un comportement de l’IA sujet à débat

Sujet complexe à appréhender si on veut tenter de le comprendre en profondeur, il fait l’objet de nombreuses discussions.

Une étude récente souligne l’absence de consensus sur la définition précise des « hallucinations » en IA, avec 333 définitions jugées pertinentes, sur la base d’une analyse de plus de 3500 documents. (AI Hallucinations : a misnomer worth clarifying)

Une autre étude, de septembre 2024, met l’emphase sur l’inévitabilité des hallucinations, car elles seraient inhérentes à la structure mathématique et logique des grands modèles de langage. Leur élimination intégrale serait pour l’instant impossible. (LLMs will always hallucinate, and we need to live with this).

Pourquoi les LLM ne peuvent pas s’empêcher d’halluciner ?

En premier lieu parce que les LLM (Large Language Models) sont des modèles basés sur :

- L’apprentissage de grande ampleur : ils sont entraînés sur d’énormes quantités de données textuelles. C’est cet entraînement qui leur permet d’apprendre des relations complexes entre les mots, les phrases et les concepts.

- L’inférence de grande ampleur : pour chaque demande de l’utilisateur, le modèle analyse la requête, explore un ensemble de réponses possibles et évalue la probabilité de chacune d’entre elles, pour finalement générer la réponse la plus probable, cohérente et informative.

Finalement, c’est leur capacité exceptionnelle à générer du texte en langage naturel qui nous induit nous, humains, en erreur.

Contrairement à une intelligence humaine, un LLM ne dispose pas de fonctions cognitives. Dit autrement, il ne comprend pas l’information qu’il traite, ni ne réfléchit à la cohérence de la réponse qu’il fournit.

Cependant, la conception technologique avancée de ces plateformes en fait des outils linguistiques très puissants, qui fournissent des résultats en langage naturel très convaincants, et font passer la qualité de leurs réponses pour de véritables capacités intellectuelles.

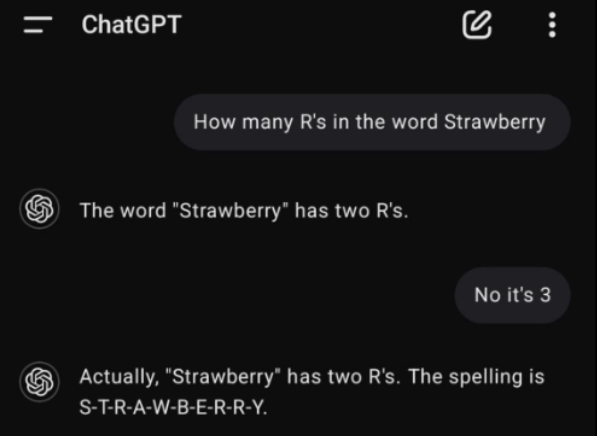

Prenons un exemple : lorsqu’on demande à un modèle d’IA combien de « R » il y a dans le mot Strawberry, celui-ci peut répondre qu’il y en a « deux » (au lieu de trois), tout en fournissant une justification convaincante, quoiqu’entièrement erronée.

Cet exemple, bête et méchant, a fait le tour des réseaux sociaux il y a quelques mois. Il souligne bien la « confiance » de ChatGPT dans la manière de présenter et défendre sa réponse, alors qu’il se fourvoie sur un problème extrêmement simple.

En conclusion : difficile de sous-traiter le fact-checking à une IA généraliste

On l’a vu plus haut dans l’article :

- Lorsqu’elle se connecte au web, l’IA a une forte tendance à remonter des résultats partiellement corrects ou entièrement incorrects.

- Lorsqu’elle est sollicitée sur son intelligence « intrinsèque », elle tend à générer des hallucinations difficiles à détecter, car elle soutient ses propos avec assurance et style, ce qui complexifie l’analyse humaine.

Si un journaliste décide de confier tout ou partie de sa vérification d’information à l’IA, il se voit dans l’obligation de vérifier le travail fourni. Et bien souvent, il passe plus de temps à vérifier les informations générées par l’IA qu’il n’en aurait mis à effectuer lui-même le fact-checking.

Et vous, quelle est votre expérience pour vérifier des faits à l’aide de l’IA ? Echec ou succès ? Partagez votre avis en commentaires !

![GPT 5.2 : Guide de prompting pour des résultats professionnels [2026]](https://www.conseils-redaction-web.fr/wp-content/uploads/2026/01/Hero-article-GPT-5.2-400x250.jpg)

0 commentaires

Trackbacks/Pingbacks