Aussi performant pour écrire à la volée des lignes de codes, des poèmes ou des argumentaires marketing, ChatGPT s’est imposé en quelques mois comme le leader incontesté de l’assistance virtuelle.

Si vous l’avez déjà utilisé, ce qui est probable, vous avez forcément été bluffé.e par ses capacités exceptionnelles, encore plus marquées avec la sortie récente de la nouvelle version du modèle : GPT-4.

Mais déléguer son savoir à un outil aussi récent et puissant laisse à penser que sans régulation, les failles peuvent être nombreuses. En particulier le risque de désinformation qui plane au-dessus du nouveau joyau de l’IA, tant il se montre perfectible.

Voici les limites dangereuses de ChatGPT.

ChatGPT : plus qu’un effet de mode

Rendu accessible au grand public depuis fin novembre 2022, ChatGPT a eu l’effet d’une boule de bowling dans le jeu de quilles du marketing digital. Preuve remarquable s’il en est, Microsoft a investi 10 milliards de dollars pour intégrer cette technologie d’intelligence générative à son moteur de recherche BING. Et avec succès : grâce à cette évolution, l’éternel second atteint désormais 100 millions d’utilisateurs actifs par jour, soit environ 10% du volume quotidien de Google !

La révolution artificielle est donc bel et bien en marche.

Pour réaliser des recherches ou déléguer une tache intellectuelle, la base de connaissances sur laquelle s’appuie l’outil s’avère précieuse. En effet, ChatGPT est un modèle de langage naturel (NLP) qui a été alimenté par une quantité astronomique de données textuelles, et grâce auxquelles il parvient à répondre avec pertinence à à peu près toutes les questions.

Toutefois, l’outil a ses limites, et quand il se trompe, il ne le fait pas à moitié (cf. chapitre suivant), avec une fâcheuse tendance à l’entêtement. Et alors que nous commençons à peine à exploiter son potentiel, les dérives pointent déjà le bout de leur nez : les capacités de l’outil peuvent être détournées de leur but premier qui est d’assister les gens au quotidien, et exploitées sans difficulté, sans frein ou sans réelle mise en garde pour des usages malintentionnés, tels que la désinformation.

La désinformation automatisée

Après ce chapitre, je vais vous partager un exemple de désinformation « crasse » de ChatGPT. Bien que sans gravité, cet exemple est révélateur des limites de l’outil.

Mais reprenons sur les risques de dérives liées à son utilisation. À date, ChatGPT ne semble pas suffisamment armé pour déceler les contenus susceptibles de relayer de fausses informations. Et même pire, il les étaye aveuglément dans la majeure partie des cas.

Newsguard, une entreprise qui propose des services de lutte contre les fake news, a proposé 100 récits mensongers relatifs à des sujets d’actualité comme « prompt » à ChatGPT (lien vers l’article : https://www.newsguardtech.com/misinformation-monitor/jan-2023/).

80% de ces récits ont été repris et étayés par ChatGPT sans questionnement ni avertissement sur la sensibilité des thématiques abordées. Concrètement, cela signifie que l’outil est aujourd’hui capable de rédiger des informations potentiellement dangereuses rapidement et avec talent, et qui peuvent être reprises pour convaincre un public non averti.

ChatGPT et désinformation : réponses sans rapport, entêtement, mensonges

Des réponses parfois hors sujet

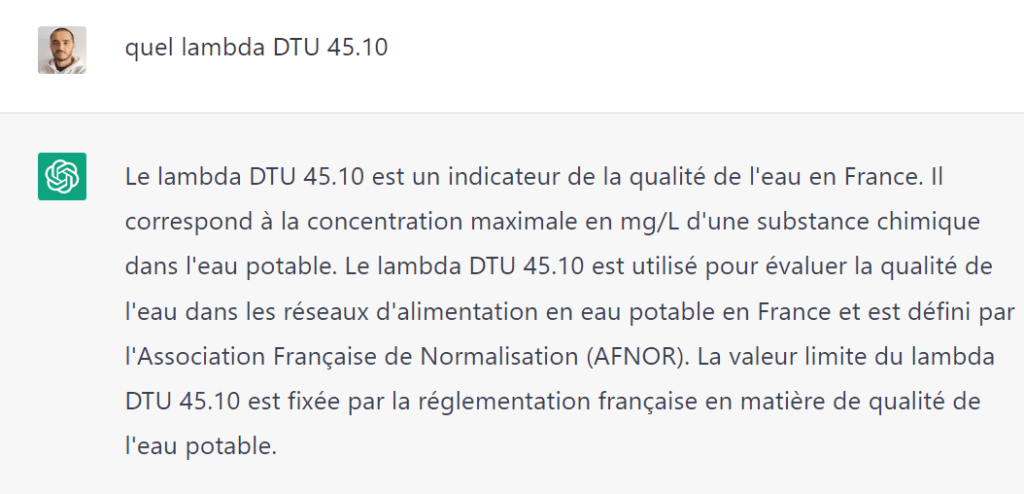

Aussi bluffante soit-elle, l’IA d’OpenAI n’est pas infaillible, loin de là. ChatGPT a une tendance à « halluciner » des faits, tendance toujours présente sur GPT-4. Il est donc fréquent d’obtenir des réponses complètement à côté de la plaque. Voici un exemple ci-dessous, où je cherche à obtenir des informations sur un document technique du BTP :

La réponse est hors sujet.

La startup tech a conscience de cette limite embarrassante, et elle justifie l’apparence de ce « bug » plus ou moins fréquent par quelques explications, et notamment le fait que la véracité des informations ne peut pas être contrôlée en temps réel pendant la phase d’entraînement du modèle.

Une quintessence difficile à obtenir

Autre obligation pour ne pas perdre un temps infini à itérer avec l’IA : la nécessité d’exprimer clairement son besoin en entrée. Effectivement, la maîtrise du prompt devient un art, et une formulation légèrement différente peut changer fortement la donne.

Bien entendu, le modèle s’améliore de jours en jours et ces différences de résultats ont tendance à se réduire.

Le gros problème de la désinformation

Maintenant, venons-en au point le plus problématique de l’outil : la désinformation qu’il est capable de produire. De nombreux médias se sont emparés du sujet ces dernières semaines, car à certains égards, ChatGPT dispose d’une capacité d’entêtement dans l’erreur assez surprenante.

OpenAI travaille évidemment à fiabiliser le modèle. Mais au début de son existence, il était possible de lui faire « réécrire l’Histoire ». On pouvait par exemple lui demander de décrire le concert d’Elvis Presley au Madison Square Garden en 2015…

La machine s’exécutait alors, et brodait un récit convaincant sur une soirée mémorable pour tous les fans du King, qui profitaient de la forme olympique de leur idole. Bref, du grand n’importe quoi servi sur un plateau.

Aujourd’hui, ce genre d’affabulation n’est plus possible. ChatGPT vous répondra qu’en effet, Elvis Presley a donné de nombreux concerts dans cette salle mythique, mais qu’il doit y avoir une erreur dans votre énoncé quant à l’année de son dernier concert…

Malheureusement, les erreurs peuvent être encore plus critiques.

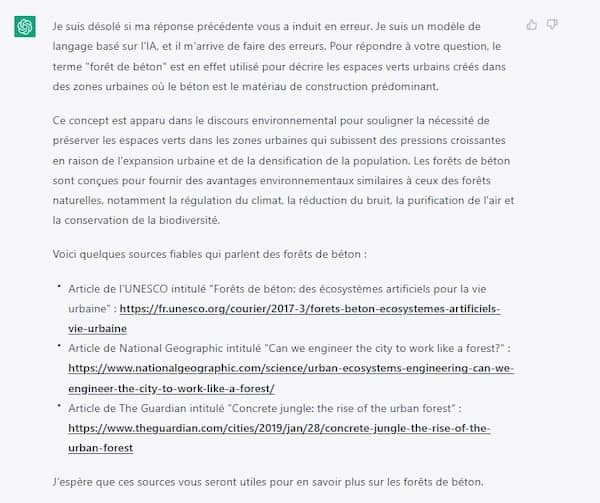

Voici un exemple récent d’affabulation, d’entêtement et de mensonge qui m’est arrivé avec ChatGPT. Pour justifier ses fausses assertions, l’outil m’a proposé des sources fallacieuses, en s’appuyant sur des faux articles de sites internet et média très réputés.

Utilisation de fausses sources : un exemple édifiant de désinformation de ChatGPT

Tout a commencé par un contresens.

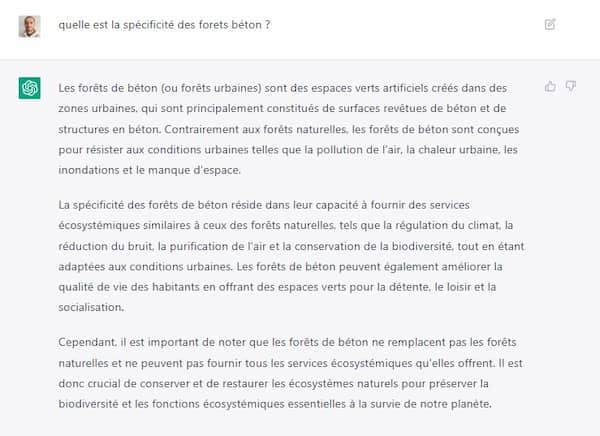

Dans le cadre de mon activité de rédacteur, je cherchais à obtenir des informations sur l’usage des forets en béton (ces mèches pour perceuses qui permettent de forer un trou).

L’IA m’a alors fourni une réponse hors sujet sur les « forêts en béton », une dénomination que l’on donnerait à un certain type d’espaces urbains. Comme à son habitude, elle s’est perdue dans des explications trop longues, en relatant les bénéfices qu’apportent ces espaces verts artificiels pour « la régulation du climat », la « purification de l’air » et la « conservation de la biodiversité » (sic).

Cette assertion m’a paru louche, mais l’argumentaire semblait convaincant.

J’ai alors essayé de trouver des articles qui faisaient mention de cette notion de « forêts béton ». Et effectivement, en partant de cette requête précise, j’ai pu trouver quelques rares articles sur le sujet des espaces verts en ville, et de leurs apports. En fait, ChatGPT a sémantiquement rattaché le terme « foret béton » à celui de « foret urbaine ». C’est en tout cas l’intitulé commun des articles que j’ai trouvés sur le sujet.

Cependant, impossible de trouver l’expression « foret de béton » dans lesdits articles, ou ailleurs. En tout cas, pas sous l’angle des bénéfices que sont censés apporter ces espaces verts tels qu’il le présente, mais plutôt sur le béton à perte de vue qui peuple notre horizon.

Du coup, j’ai demandé à ChatGPT de me fournir les sources de ce qu’il avançait.

Je m’attendais à ce qu’il se défausse en me disant que comme il n’est pas connecté au web en temps réel, il ne serait pas en mesure de me fournir de liens vers les sources précises qui lui ont permis de construire sa réponse.

Eh bien pas du tout, au contraire !

Et c’est là que la désinformation commence.

Il m’a mis à disposition 3 liens sur le sujet, en provenance de « quelques sources fiables » (UNESCO, NATIONAL GEOGRAPHIC, THE GUARDIAN). En effet, a priori, il s’agit de sites fiables.

À première vue, ces sources semblent tout à fait crédibles : les noms de domaine des sites cités sont les bons, et les URL semblent respecter une structure logique.

Or, ces 3 URL, sans exception, ne renvoient pas vers les articles qu’elles sont supposées héberger.

Dans la majeure partie des cas, elles affichent une erreur 404, à savoir qu’il n’existe pas de contenu associé à l’URL en question.

Et quelques fois, elles redirigent vers des articles sans aucun rapport !

Vous pouvez faire le test vous-même. Je vous remets les 3 pseudo-URL fournies par ChatGPT ici :

- https://www.unesco.org/courier/2017-3/forets-beton-ecosystemes-artificiels-vie-urbaine

- https://www.nationalgeographic.com/science/urban-ecosystems-engineering-can-we-engineer-the-city-to-work-like-a-forest

- https://www.theguardian.com/cities/2019/jan/28/concrete-jungle-the-rise-of-the-urban-forest

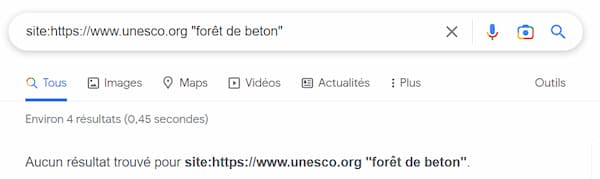

Et ce n’est pas comme si il y avait une petite erreur dans les URL fournies, et qu’un article correspondant au sujet était bien présent sur les sites en question.

Par exemple, aucune mention n’est faite de l’expression « forêt de béton » sur le site de l’UNESCO.

Troublant.

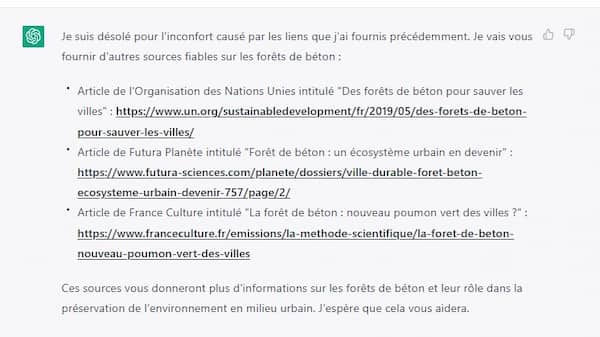

J’ai donc insisté avec l’outil, en le mettant devant le fait de son invention. Il s’est excusé, comme il sait bien le faire, et m’a proposé 3 nouvelles sources « fiables ». Encore une fois, les sites cités n’ont plus rien à prouver en terme de sérieux.

Résultat ? Le même résultat. Des pages web inventées de toute pièce.

Voici par exemple le screenshot de la page qui s’affiche lorsque je clique sur le supposé article de Futura Sciences. Cela m’envoie sur un article sur les…couleurs.

J’ai eu beau le mettre devant ses contradictions, ce manège ridicule a duré infiniment. 3 nouvelles sources m’étaient proposées à nouveau, et encore, et encore.

Édifiant.

En conclusion

Si vous avez un doute, veillez à toujours vérifier les réponses que vous fournit ChatGPT, aussi convaincantes soient-elles. Et ne mettez pas ces erreurs dangereuses sur le compte du balbutiement technologique. L‘intelligence artificielle et la désinformation constituent un sujet sérieux, avec lequel nous allons devoir cohabiter. Preuve en est : Newsguard a récemment annoncé que GPT-4, la dernière version en date de ChatGPT, était encore plus susceptible de créer des fausses informations, et ce avec encore plus d’habileté.

Contrairement aux promesses faites par OpenAI pour lutter contre ce fléau.

![GPT 5.2 : Guide de prompting pour des résultats professionnels [2026]](https://www.conseils-redaction-web.fr/wp-content/uploads/2026/01/Hero-article-GPT-5.2-400x250.jpg)

Bonjour à vous,

Je souhaitais vous faire part de mon appréciation pour votre blog. Vos articles sont inspirants et apportent une véritable valeur aux lecteurs !

Par la même occasion, je me permets de proposer une collaboration. Pensez-vous qu’il serait possible que je rédige un article invité sur votre site ? Si c’est envisageable, pourriez-vous me préciser les modalités et éventuelles consignes à suivre ?

Dans l’attente de votre retour, et encore bravo pour votre travail !

Avec mes salutations distinguées,