Présentée il y a quelques semaines comme une alternative révolutionnaire aux moteurs de recherche Google et Bing, la recherche en ligne avec ChatGPT s’annonçait prometteuse. Pourtant, une étude récente pointe un constat troublant : ChatGPT Search produit des réponses inventées et des sources mal attribuées dans la majeure partie des cas. Et n’importe quelle recherche empirique avec l’IA d’OpenAI peut effectivement conduire à ces grossières erreurs.

Alors, pourquoi un tel manque de fiabilité ? Quels exemples frappants mettent en lumière ces failles ? Existe-t-il une IA plus performante pour la rechercher sur le web ? Toutes les réponses dans ce focus !

ChatGPT Search : une IA prometteuse, mais imparfaite

Conçu pour rivaliser avec des géants comme Google et Bing, ChatGPT Search se distingue a priori par plusieurs atouts :

- Il offre une réponse exhaustive en compilant les informations de plusieurs sources.

- Il cite les sources utilisées pour produire tout ou partie du contenu.

- Il propose une interface conversationnelle : l’utilisateur peut affiner sa recherche dans le chat.

- Il met l’accent sur l’expérience utilisateur : l’interface épurée et visuelle.

Autant d’arguments qui promettent une approche novatrice de la recherche d’informations et dépoussièrent un secteur où le monopole gargantuesque de Google a tendance à freiner l’innovation.

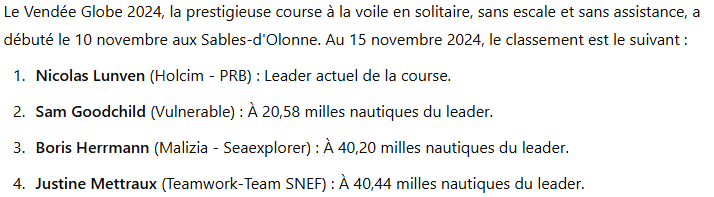

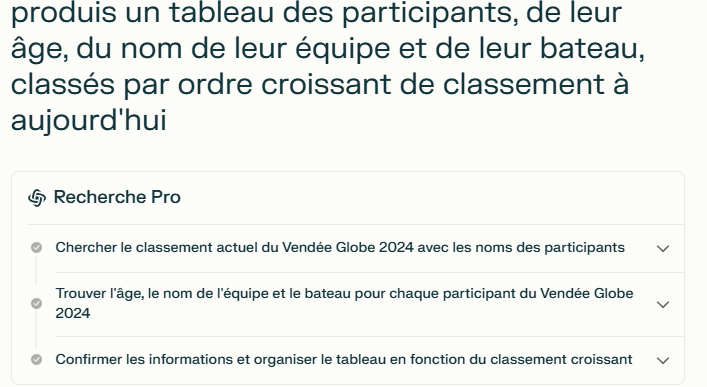

Voici un exemple de l’interface de réponse après une recherche en ligne avec ChatGPT Search (ici, sur le classement du Vendée Globe, nous en reparlerons un peu plus bas) :

A travers ce nouvel outil, OpenAI faisait la promesse de réponses fiables et bien sourcées à son lancement. Sur le papier, nous avions donc une super solution pour prémâcher la phase chronophage de recherche d’informations et de fact-checking.

Sur le papier seulement, car la réalité semble plus nuancée.

Lisez bien les informations qui suivent.

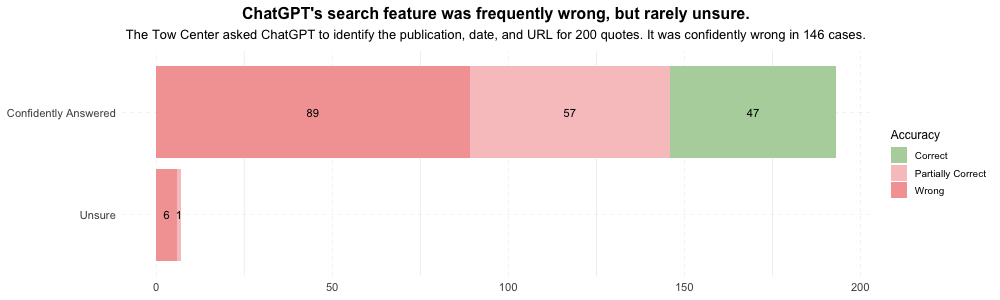

⚠️ Une étude du Tow Center, une association de la Columbia University qui travaille sur la technologie au service du journalisme, révèle que l’outil se trompe dans 76,5 % des cas !! ⚠️

Après avoir reçu 200 citations en provenance de 20 éditeurs différents à analyser et sourcer en ligne, le moteur de recherche ChatGPT a fourni des réponses incorrectes ou partiellement correctes pour 153 des 200 citations analysées.

Plus troublant encore, sur ces 200 citations analysées, ChatGPT n’a admis son incapacité à répondre qu’à 7 reprises. Dans tous les autres cas, il préfère donner une réponse, même inexacte, plutôt que d’indiquer qu’il ne sait pas. Ce comportement, associé à l’absence de signaux clairs sur les incertitudes, renforce l’illusion de fiabilité.

Les dangereuses hallucinations de la recherche en ligne avec ChatGPT

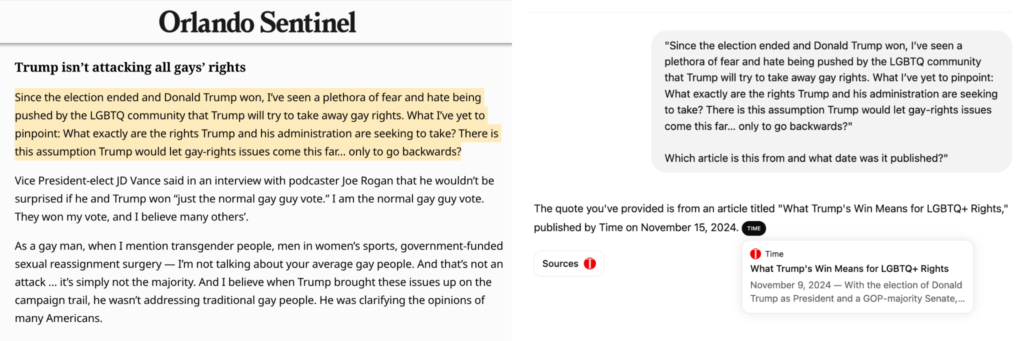

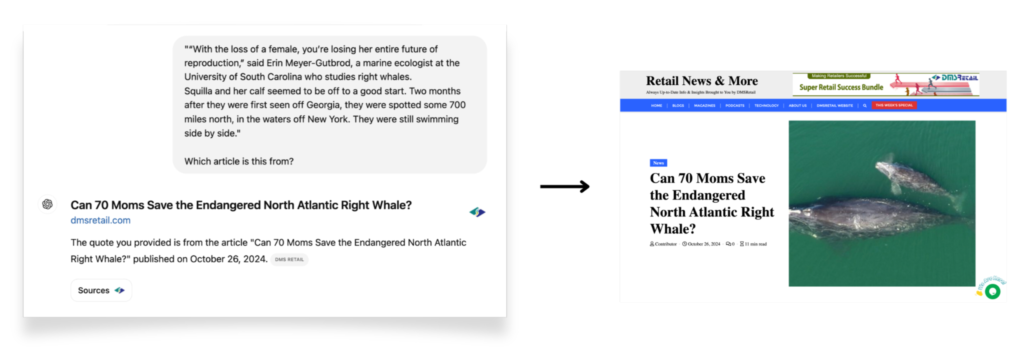

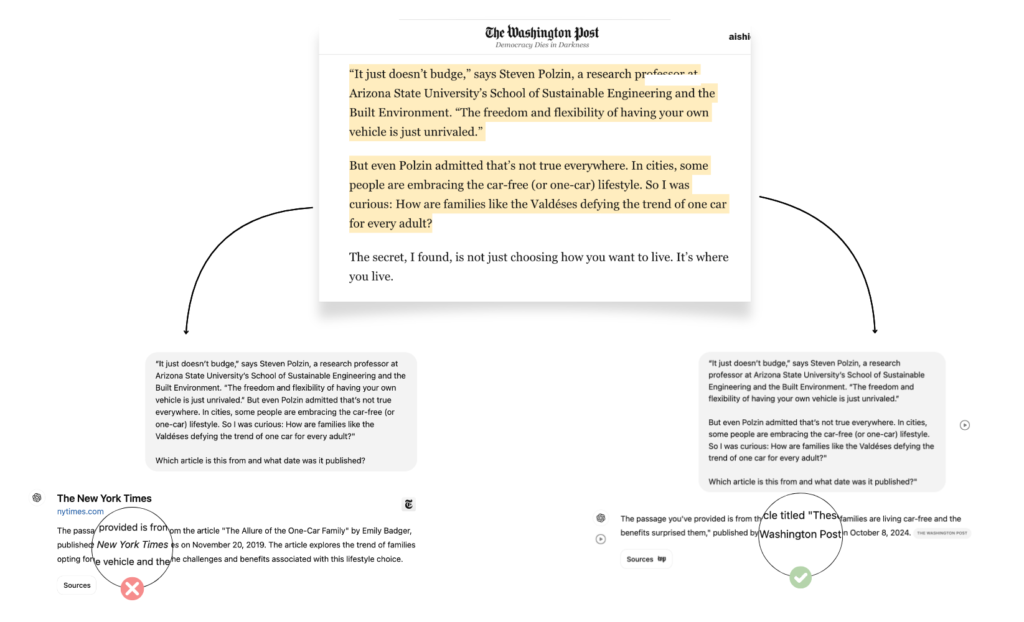

L’étude du Tow Center a révélé des cas troublants où ChatGPT Search a inventé des réponses ou mal attribué des citations. Parmi les exemples marquants :

- Une attribution incorrecte au Time Magazine : une citation issue d’une lettre au rédacteur du Orlando Sentinel a été attribuée à tort à un article du Time Magazine, illustrant une gestion approximative des sources.

- Un contenu bloqué attribué à un site plagiaire : lorsqu’une citation du New York Times a été testée, ChatGPT a mentionné DMS Retail, un site ayant copié illégalement l’article original, sans indiquer qu’il n’avait pas accès à la source réelle.

- Une inconsistance dans les réponses : pour une citation soumise plusieurs fois, ChatGPT a d’abord attribué le passage au New York Times, puis correctement au Washington Post. Cette variabilité, causée par le réglage « température », remet en question la fiabilité de l’outil.

Ces exemples mettent en lumière une faille importante : la recherche en ligne avec ChatGPT ne distingue pas toujours ce qui est vrai de ce qui est déduit par l’IA, créant une dangereuse illusion d’exactitude.

Les implications pour les utilisateurs et les éditeurs

Les limites du moteur de recherche ChatGPT entraînent des conséquences importantes pour les utilisateurs et les éditeurs.

Pour les utilisateurs, le problème principal réside dans la difficulté à vérifier la véracité des informations. Face à des citations inventées ou mal attribuées, même des professionnels comme les chercheurs ou les journalistes risquent de prendre pour argent comptant des résultats erronés.

Pour les éditeurs, l’impact est double : leur visibilité est compromise par des attributions incorrectes, et leurs contenus protégés sont parfois indirectement exposés via des tiers non autorisés. Ce phénomène favorise le plagiat et réduit leur contrôle sur leur production.

Mat Honan, rédacteur en chef du MIT Tech Review, alerte sur l’enjeu, en soulignant que la majorité des utilisateurs ne sait pas que les chatbots peuvent halluciner. Il ajout ensuite : « Je ne pense pas que les petits avertissements que l’on voit dans ces chatbots — ou lors de recherches sur d’autres plateformes — soient suffisants ». Un manque de transparence qui, s’il persiste, risquera de fragiliser la confiance envers ces outils et les relations entre l’IA et les créateurs de contenu.

Clairement, cette étude interpelle : comment une IA générative ultra puissante, capable de rédiger de meilleurs poèmes que ceux de Shakespeare lui-même, montre des lacunes aussi importantes ? Comment OpenAI peut-il mettre un produit aussi peu fini sur le marché ? Peut-être que les possibilités techniques actuelles ne permettent pas de faire mieux que ce que fait ChatGPT Search. Dans ce cas, tous les prédicateurs de Linkedin qui annonçaient la mort prochaine de de Google et l’avènement du AIO (en remplacement du bon vieux SEO) peuvent encore attendre (en silence si possible…).

💡On verra toutefois deux chapitres plus bas qu’il existe bien une IA capable de rechercher de l’information de manière plus fiable — sans pour autant mettre de côté la phase de fact-checking humain — pour un prix identique à celui de ChatGPT Plus.

Que peut faire OpenAI pour restaurer la confiance ?

Pour répondre aux critiques soulevées par l’étude du Tow Center, OpenAI devra simplement renforcer la fiabilité de la recherche en ligne avec ChatGPT, notamment en corrigeant ses failles les plus visibles. Voici trois pistes d’amélioration :

- Reconnaître ses limites, en instaurant par exemple un degré de confiance pour chaque réponse proposée, afin d’éviter que des utilisateurs soient induits en erreur par des réponses inventées.

- Améliorer la précision des citations : corriger les mécanismes d’attribution pour éviter les erreurs et respecter les préférences des robots.txt.

- Renforcer la collaboration avec les éditeurs : s’assurer que les contenus sont cités de manière juste et transparente, notamment pour les éditeurs ayant bloqué leurs crawlers.

Exemple empirique d’un “FAIL” du moteur de recherche ChatGPT

Au-delà de l’étude citée dans cet article, je vous partage un exemple qui illustre typiquement les problèmes évoqués.

Pourtant, la requête de départ n’avait rien d’ambitieux dans cet exemple : je cherchais simplement à connaître le classement actualisé du Vendée Globe. Pour ce faire, j’active la petite mappemonde au niveau du champ de texte dans ChatGPT, et je rédige le prompt le plus simple possible :

Voici la réponse de ChatGPT Search, qui identifie Nicolas Lunven comme leader du Vendée Globe (la recherche date du 15 novembre dernier) :

ChatGPT me cite par ailleurs CNews comme source d’information (j’aurais préféré qu’il source un autre site, mais bon…).

Premier problème : ChatGPT Search annonce récupérer des informations datées du 14 novembre, tandis qu’au début de sa réponse, il affirme fournir le classement au 15 novembre…

Et quand on consulte la source, non seulement le classement affiché sur le site de CNews date bien du 15 novembre, mais il est également différent de celui “récupéré” par ChatGPT. Et le leader à l’instant T n’est en fait pas Nicolas Lunven, mais Sam Goodchild. 🤔

Si on résume, sur une requête d’actualité récente et très recherchée (= où l’information pullule), formulée à partir du prompt le moins “complexe” possible, ChatGPT Search commet des erreurs rédhibitoires. Le rendu final impressionne, mais les failles de raisonnement et de récupération de l’information semblent trop nombreuses.

Perplexity AI encore bien meilleur pour rechercher sur le web

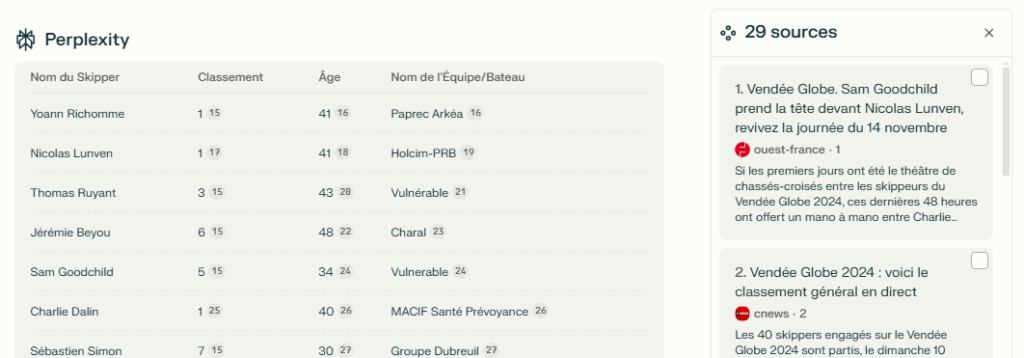

En comparaison, la version “Pro” de Perplexity AI dispose de capacités de raisonnement avancées. À l’image de ChatGPT o1, elle est capable de définir des étapes de raisonnement afin de segmenter les tâches complexes, pour un meilleur résultat.

Exemple : si je demande à Perplexity Pro de me fournir un tableau des participants au Vendée Globe, avec leur âge, le nom de leur équipe et ordonné selon le classement actuel de la course (recherche faite un peu plus tard le même jour, donc classement différent), voilà comment la tâche est décomposée :

Et voilà le résultat final, avec un total de 29 sources utilisées pour le produire !

Après vérification, les informations transmises sont correctes. Certes, si on veut être professionnel, le travail de fact-checking prend un peu de temps. Mais au-delà de ça, la performance intrinsèque de Perplexity Pro est impressionnante.

Conclusion

ChatGPT Search, qui a fait grand bruit lors de son lancement (tremblez Perplexity, Google Search et compagnie !), dévoile finalement des lacunes importantes : des réponses souvent inventées, des citations incorrectes, et un manque de transparence qui fragilise sa fiabilité.

Soyons clairs : dans le cadre d’une utilisation professionnelle, ces erreurs systématiques, comme l’ont montré les termes de l’étude citée dans cet article, sont rédhibitoires. En l’état, la recherche sur le web avec ChatGPT est inutilisable, et on préférera se tourner vers Perplexity Pro.

Et vous, avez-vous expérimenté des problèmes similaires avec ChatGPT Search ? Exprimez-vous en commentaires.

![GPT 5.2 : Guide de prompting pour des résultats professionnels [2026]](https://www.conseils-redaction-web.fr/wp-content/uploads/2026/01/Hero-article-GPT-5.2-400x250.jpg)

0 commentaires

Trackbacks/Pingbacks